Actualmente vivimos en una realidad en la que ordenadores y algoritmos deciden qué pacientes están en una lista de cirugía prioritaria en un hospital público, detectan el fraude entre las personas que cobran prestaciones o ayudas públicas y determinan la gravedad de un incidente de violencia doméstica. Estos servicios se desarrollan e implementan a través de nuestros gobiernos con poca o ninguna transparencia sobre cómo, cuándo o por qué los ordenadores y algoritmos están tomando estas decisiones.

Basándose en el trabajo del manual de contratación de IA de la Universidad de Nueva York, Platoniq y Civio organizaron un taller para preguntarse cómo podríamos crear procesos más transparentes para la contratación pública y el diseño de IA, utilizando marcos de participación y gobernanza como Decidim.

A menudo, la contratación y el diseño se abordan a través de un proceso técnico o jurídico cerrado. El taller pretendía iniciar una conversación y empezar a desarrollar ideas sobre cómo abrir la gobernanza pública de la IA y fomentar la seguridad, la transparencia y la participación pública en los servicios y herramientas que afectan a la vida cotidiana de las personas.

Nadia Nadesan durante el taller

Decidim Fest, 2023

En la última década, hemos asistido a un aumento de las iniciativas relacionadas con el crecimiento y el desarrollo de la IA, y lo mismo ha ocurrido con el diseño y la adquisición de sistemas de IA por parte de los gobiernos. En Barcelona, algunos ejemplos de IA en la ciudad son:

- Monitorización por IA de Vigilancia en las Playas

- Clasificación por IA de Consultas Ciudadanas

- IA en servicios sociales

Aunque estos ejemplos se citan públicamente, la investigación realizada por organizaciones de la sociedad civil puso de relieve aún más casos que utilizan la puntuación social, como Viogen, Bosco o RiisCanvi, para clasificar y medir situaciones de riesgo.

Necesidad de critica en el diseño y la contratación pública de la Inteligencia Artificial

La gran verdad que subyace en el movimiento de tecnología cívica de los últimos años es que los gobiernos tienen dificultades para implantar la tecnología y, por lo general, gestionan muy mal los activos y proyectos informáticos.

El desarrollo, diseño o adquisición de bienes y servicios por parte de la Administración no es nada nuevo. Sin embargo, el uso de algoritmos en servicios y bienes públicos requiere un enfoque más crítico. El sesgo codificado y el error en la toma de decisiones al utilizar IA en los servicios públicos han aparecido en múltiples casos en toda Europa en los últimos cinco años. En la última década, casos notables de supervisión e IA en los servicios públicos han afectado gravemente a comunidades vulnerables.

Escándalo de las prestaciones por cuidado infantil en los Países Bajos

En 2013, el gobierno neerlandés desplegó un sistema de toma de decisiones basado en IA para detectar el fraude de los solicitantes de prestaciones de guardería. Este sistema utilizaba algoritmos para evaluar la probabilidad de inexactitudes en las solicitudes y renovaciones, con el fin de identificar posibles fraudes. A las personas señaladas por este sistema se les suspendieron temporalmente las prestaciones a la espera de una investigación. Para demostrar la eficacia de sus métodos de detección del fraude, las autoridades fiscales se propusieron recuperar de los presuntos defraudadores fondos suficientes para cubrir los costes operativos. A pesar de los esfuerzos por aclarar las discrepancias o la falta de información, los acusados de fraude a menudo se enfrentaban a enormes obstáculos, ya que las autoridades fiscales se negaban a dar explicaciones sobre sus decisiones. Una de las razones era que el sistema de toma de decisiones utilizaba el aprendizaje no supervisado para crear evaluaciones de riesgo. Esto suele denominarse una «caja negra», en la que se introducen datos o información sobre los beneficiarios de las prestaciones y, a continuación, la IA emite resultados; sin embargo, sigue siendo opaco o poco comprensible cómo se obtiene el resultado proporcionado. Así, no había una lógica transparente ni pruebas que explicaran por qué la IA identificaba y etiquetaba a determinadas personas como defraudadoras. En el mundo real, esto significaba que a los cuidadores, periodistas, políticos locales y a la sociedad civil en general les resultaba difícil interactuar con un sistema de este tipo y exigir una explicación o una rendición de cuentas cuando el sistema se equivocaba.

A menudo ocurría que los solicitantes (es decir, cuidadores, tutores y padres) cometían pequeños errores, como la falta de una firma o el retraso en un pago. Estos errores acarreaban la dolorosa consecuencia de devolver grandes sumas de dinero y ser tachados de defraudadores. La devolución y el etiquetado amplificaban las dificultades a las que se enfrentaban estas familias -incluidas deudas, desahucios e incluso desempleo-, lo que a su vez suponía un estrés para su salud mental y sus relaciones personales.

Decenas de miles de familias se vieron afectadas por falsas acusaciones. La polémica de las prestaciones neerlandesas por cuidado de hijos surgió en 2018 y sigue siendo un tema político importante en los Países Bajos en la actualidad. Este escándalo acabó provocando la dimisión del Gabinete neerlandés en 2021.

Puntuando a los parados en Austria

La agencia austriaca de empleo, conocida como AMS (Arbeitsmarktservice), es un organismo gubernamental encargado de ayudar a los solicitantes de empleo. En 2016, AMS inició un programa para evaluar las perspectivas de empleo de una persona dentro del mercado laboral.

Tres años más tarde, con el apoyo de un contratista externo, Synthesis Forschung, y un coste de 240.000 euros, AMS anunció la adopción de un sistema automatizado de puntuación para los solicitantes de empleo. Este sistema asigna una puntuación a cada individuo en función de diversos atributos, clasificándolos en tres grupos: El Grupo A para quienes se considera que no necesitan ayuda para encontrar empleo, el Grupo B para las personas que pueden beneficiarse de un reciclaje profesional, y el Grupo C para quienes se considera que no pueden encontrar empleo, que reciben una asistencia reducida y son remitidos a otras instituciones.

La AMS afirmó que el algoritmo mejoraba la eficiencia al dirigir los recursos hacia las personas con más probabilidades de beneficiarse de la ayuda. Sin embargo, hubo mucha preocupación por la posible discriminación inherente al proceso de toma de decisiones del algoritmo. Los fragmentos del código que se hicieron públicos revelaron que determinados factores demográficos, como el sexo, la discapacidad y la edad, se ponderaban negativamente, afectando de forma desproporcionada a las mujeres, las personas con discapacidad y los mayores de 30 años.

La consulta que daba lugar a la puntuación de empleabilidad de una persona solía durar menos de 10 minutos. En la mayoría de los casos en los que se daba una puntuación, faltaba una regulación transparente y legal, lo que a menudo se reflejaba en que no había espacio para presentar una queja o impugnar su puntuación de empleabilidad.

A partir del 1 de enero de 2021, la autoridad austriaca de protección de datos prohibió el uso del sistema. La decisión se basó en que el sistema de IA no cumplía los requisitos del GDPR. Además, la puntuación de la capacidad de una persona para obtener un empleo basada en determinados marcadores de identidad se clasificó como elaboración de perfiles para la que es necesaria una autorización legal que la AMS no cumplía en el tratamiento de datos personales.

La creación y contratación de servicios y bienes externos de IA suele tratarse con la misma actitud que cualquier otra tecnología. Sin embargo, teniendo en cuenta el impacto de la IA desde los Países Bajos hasta Austria, parece que la gobernanza en torno a la IA requiere más responsabilidad y vías de recurso. Durante la última década, los gobiernos aún no han puesto en marcha una comunicación sistemática en torno al desarrollo o el uso de sistemas de IA en el sector público.

El uso de la IA en los servicios públicos españoles

VioGén

En 2004, el Congreso europeo aprobó una ley para combatir la violencia de género que supuso la introducción de VioGén. Este sistema realiza predicciones basadas en factores de riesgo para evaluar el nivel de amenaza al que se enfrentan las víctimas de la violencia de género. Mediante el análisis de 37 indicadores de riesgo, que abarcan tanto los rasgos del agresor como la vulnerabilidad de la víctima, VioGén clasifica el riesgo en cinco niveles: no perceptible, bajo, medio, alto y extremo.

Las herramientas de evaluación del riesgo están diseñadas para clasificar los casos de violencia de género en función del nivel de riesgo previsible. Por lo tanto, pretenden ofrecer una predicción precisa de qué víctimas de violencia de género tienen más probabilidades de volver a ser agredidas y, por lo tanto, necesitan protección. Una puntuación de riesgo, en este contexto, no evalúa la gravedad de los incidentes pasados o actuales, sino que predice la probabilidad de sufrir un futuro episodio de violencia de género -lo que se evalúa es el riesgo de reincidencia del agresor-. Desde su puesta en marcha, VioGén ha valorado más de 700.000 casos de violencia de género en España hasta octubre de 2022. Sin embargo, es importante saber que no existe ninguna auditoría o análisis independiente del servicio que analice de forma crítica cómo ha mejorado o empeorado el acceso a la justicia de las víctimas de violencia de género.

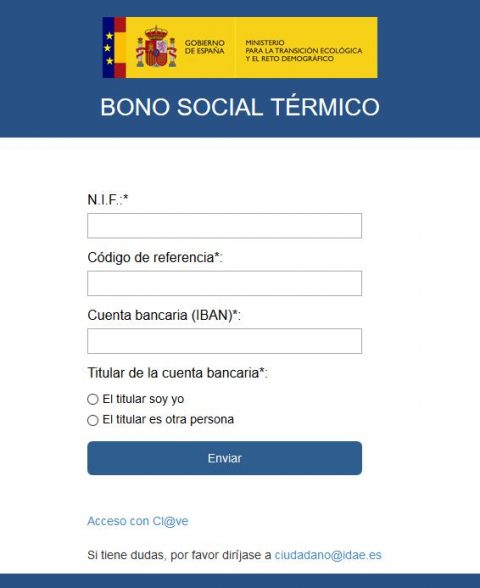

Bosco

La reciente subida de los precios de la electricidad ha agravado la pobreza energética, afectando al 16% de los hogares de Cataluña en 2021. Para mitigar los efectos de esta crisis, las medidas de apoyo social, como el programa de descuentos en el consumo eléctrico puesto en marcha por el Gobierno español, han sido fundamentales para ayudar a las familias afectadas. Sin embargo, han surgido preocupaciones en relación con el proceso de asignación tras los cambios en los criterios de elegibilidad y la introducción del programa informático BOSCO en 2017. Para aumentar la transparencia y garantizar la rendición de cuentas, la Fundación Civio desarrolló un simulador BOSCO en 2018 para evaluar la funcionalidad del sistema. Sin embargo, los resultados generados por el simulador plantearon dudas sobre la eficacia y la equidad del proceso de asignación. En cumplimiento de la Ley de Transparencia, Civio solicitó acceso a la información relativa a BOSCO, incluido su código fuente, para profundizar en su funcionamiento. Aunque el Gobierno español facilitó especificaciones técnicas y datos de prueba, no permitió el acceso al código fuente del software (actualmente en el Tribunal Supremo), lo que suscitó nuevas dudas sobre la transparencia y la responsabilidad del proceso de asignación.

También hay que señalar que, en el caso del régimen de ayudas, la aplicación fue desarrollada íntegramente por el Ministerio de Transición Ecológica y no por un tercero.

RisCanvi

RisCanvi es un sistema de inteligencia artificial desarrollado para calcular el riesgo de futuros comportamientos violentos de personas encarceladas. Se desarrolló originalmente para delincuentes violentos acusados de muerte o lesiones corporales graves. Sin embargo, desde entonces se ha ampliado y RisCanvi se utiliza para identificar si una persona tiene un riesgo bajo o alto de reincidencia, lo que a su vez informa sobre cómo trata su caso el Estado.

En las prisiones catalanas y en toda España, los reclusos son supervisados y evaluados por la Junta de Tratamiento, que incluye trabajadores sociales, abogados, psicólogos, etc., que revisan el progreso de la persona encarcelada. Antes de RisCanvi, la evaluación de si una persona iba a reincidir la hacían médicos. Ahora, las observaciones de la Junta de Tratamiento se agregan en una lista de control de 43 factores de riesgo que tienen en cuenta el sexo, la edad, la presentación de conductas antisociales, la duración de su condena, la salud mental, las visitas familiares, el historial de relaciones familiares, la participación en actividades de ocio, etc. Estos factores de riesgo se analizan con RisCanvi, que predice si una persona encarcelada reincidirá. Un estudio de Bikolabs muestra que 9 de cada 10 funcionarios confirman la decisión tomada por RisCanvi. Sin embargo, ¿es esto una señal del éxito del sistema o un motivo de preocupación? Un estudio reciente concluye que RisCanvi puede detectar a 8 de cada 10 presos reincidentes, aunque 2 son falsos negativos. Además, al examinar la capacidad de Riscanvi para identificar a quienes no reincidirán, se demostró que 4 de cada 10 veces los delincuentes no reincidentes son identificados erróneamente como de alto riesgo.

Entonces, ¿qué define el éxito de este sistema? ¿Es la confianza de los funcionarios que lo utilizan? ¿Es su aplicación generalizada? ¿O cómo se mide en términos de precisión y especificidad? Parte de la creación de una gobernanza más participativa en la IA consiste en definir colectivamente lo que hace que un servicio o bien público tenga éxito. ¿Es posible incorporar las voces de los más afectados por la IA en su diseño y aplicación?

Gobernanza de la IA

Un aspecto crítico de la gobernanza de la IA en todo el mundo reside en la actual falta de estructuras o prácticas comunes que permitan una mayor transparencia y responsabilidad en torno a los procesos de toma de decisiones. Aunque los sistemas de IA se están integrando cada vez más en los servicios públicos, a menudo hay poca claridad sobre cómo los afectados pueden impugnar y recurrir cuando los sistemas propagan sesgos discriminatorios, generan errores o funcionan mal. Además, la ausencia de medidas de rendición de cuentas significa que los errores o sesgos de los sistemas de IA pueden quedar sin control, perpetuando las desigualdades y socavando la confianza pública. Por ello, se necesitan marcos de gobernanza sólidos que den prioridad a la transparencia, la rendición de cuentas y los espacios para que la sociedad civil y las comunidades afectadas influyan de manera significativa en la dirección de los servicios que aplican la IA. Sin salvaguardias, la adopción de la IA en los servicios públicos corre el riesgo de exacerbar las disparidades sociales existentes y erosionar la confianza pública en las instituciones gubernamentales.

la ausencia de medidas de rendición de cuentas significa que los errores o sesgos de los sistemas de IA pueden quedar sin control, perpetuando las desigualdades y socavando la confianza pública.

Gobernanza de la IA en España

Una vía para mejorar la gobernanza de la IA es el establecimiento de organismos reguladores independientes, similares a la Agencia Española para la Supervisión de la Inteligencia Artificial (AESIA). Siguiendo el modelo de entidades como la Agencia Española de Protección de Datos (AEPD) y la Comisión Nacional de los Mercados y la Competencia (CNMC), AESIA operaría de forma autónoma respecto a otras autoridades públicas, garantizando así una supervisión imparcial de las aplicaciones de IA en el sector público.

Además, las estrategias municipales, como la aplicada en Barcelona, subrayan la importancia de la participación de múltiples partes interesadas en la gobernanza de la IA. Mediante la creación de comités interdepartamentales en los ayuntamientos, los municipios pueden garantizar que las soluciones basadas en la IA se someten a un examen exhaustivo y a procesos de aprobación. Además, la inclusión de consejos de IA formados por investigadores, académicos y miembros de la sociedad civil fomenta la diversidad de perspectivas y garantiza que las consideraciones éticas sigan estando en el primer plano de la toma de decisiones.

La sociedad civil y la gobernanza de la IA en Europa

En Europa existen iniciativas específicas, como los registros de IA, para hacer más visibles los tipos de servicios y herramientas de IA que se están implantando en la ciudad. Por ejemplo, Barcelona forma parte de la iniciativa Ciudades por los Derechos Digitales y tiene previsto crear un registro de IA, una comisión para promover la IA ética en el Ayuntamiento de Barcelona, un consejo asesor de expertos en IA y poner en marcha un órgano de participación ciudadana.

Sin embargo, a menudo hay una falta de supervisión en los sistemas automatizados de toma de decisiones que se utilizan para citar el uso de la IA por parte de la ciudad y que se dejan en manos de la sociedad civil para que los investigue.

Conclusión

A medida que los sistemas de IA se integran cada vez más en los servicios públicos, se hace imperiosa la necesidad de una gobernanza transparente y responsable. Casos recientes, como el escándalo de las prestaciones neerlandesas de guardería y el sistema austriaco de puntuación del empleo, ponen de relieve el daño potencial cuando los sistemas de IA carecen de supervisión y transparencia. Estos sistemas funcionan a menudo como «cajas negras», dejando a las personas afectadas sin recursos para impugnar errores o sesgos. A medida que los servicios públicos dependen más de la IA, es esencial implantar marcos de gobernanza sólidos que incluyan la participación de la sociedad civil, auditorías independientes y vías claras de rendición de cuentas para evitar la perpetuación de las desigualdades y restablecer la confianza pública en las instituciones gubernamentales.

El taller, facilitado por Platoniq y Civio, se centró en explorar formas de crear procesos de contratación y diseño de IA más transparentes aprovechando marcos como Decidim, una plataforma diseñada para la gobernanza participativa.

El objetivo del taller era plantar las semillas de lo que podría ser en la práctica la concienciación y la gobernanza participativa de la IA. Se fomentó el debate abierto entre expertos, residentes, sociedad civil y personas interesadas para abogar por un modelo de gobernanza más democrático en el que los ciudadanos, los investigadores y la sociedad civil colaboren para dar forma a cómo se diseñan y utilizan las herramientas de IA en los servicios públicos. En última instancia, trabajar en la comunidad Decidim nos permitió poner en práctica la noción de crear vías abiertas y accesibles para la participación pública en la gobernanza de la IA, alejándonos de los procesos cerrados y técnicos que actualmente dominan la implantación de la IA en los gobiernos.

Nota:

El taller facilitado por Platoniq y Civio, tuvo lugar en el Decidim Fest de 2023. La participación en Decidim Fest desempeñó un papel crucial a la hora de iniciar conversaciones sobre la transparencia y la rendición de cuentas en la gobernanza de la IA.